In diesem Beitrag beschäftigen wir uns damit, wie schnell Datenmengen während des Livestreamings vom Sender zum Empfänger gelangen: Das ist die sogenannte Round-Trip-Time (RTT). Hierbei spielt die Latenz eine entscheidende Rolle. Die größte Herausforderung des Multimedia-Livestreamings ist es, eine Balance zwischen einer geringen Latenz, hoher Qualität und möglichst vielen Teilnehmerinnen und Teilnehmern zu finden. Eine pauschale Antwort, welche Einstellungen am besten sind, gibt es nicht. Aber mit unseren Hinweisen und Erklärungen zu diesem komplexen Thema wird es Dir zukünftig leichter fallen, zu entscheiden, welche Latenz-Einstellungen für welche Livestream-Vorhaben passend sind.

Inhaltsverzeichnis

+

Die Latenz beim Livestreaming: Was ist das?

Beim Livestreaming ist unter Latenz die Verzögerung zwischen der Aufnahme eines Ereignisses und der Übertragung davon an die Empfängergruppe zu verstehen. Sie wird durch verschiedene Faktoren wie der Video- und Audioqualität, den Datenmengen und der Publikumsanzahl beeinflusst. Latenzen entstehen an verschiedenen Stellen: beim Live-Encoding, beim Streamingserver und beim Videoplayer. Livestreams mit geringer Latenzzeit sind häufig gefragt, weil sie schnelle Reaktionen der Zuschauerinnen und Zuschauer und damit ein interaktiveres Streamingerlebnis ermöglichen. Allerdings führen sehr geringe Latenzen manchmal dazu, dass der Stream ins Stocken gerät, dazu später mehr. Mit zunehmender Latenzzeit kann es schwierig werden, halbwegs fließend miteinander zu kommunizieren, da der zeitliche Versatz zu langsameren Interaktionen führt. Längere Latenzen sind aber dennoch für manche Streaminganwendungen nicht gleich schlecht. Es kommt immer auf die Voraussetzungen an: Wie viele Zuschauerinnen und Zuschauer nehmen teil? Welche Datenmengen werden übertragen? Sind Interaktionen während des Streamings geplant?

Was bedeutet niedrige Latenz?

Um in einem Gespräch in Videocalls, Konferenzen oder Workshops miteinander sprechen zu können, ohne einander zu unterbrechen, brauchen wir eine niedrige Latenz bei der Datenübertragung. In der Regel spricht man von einer niedrigen Latenz beim Streaming, wenn diese weniger als 250 Millisekunden beträgt.

Was bedeutet hohe Latenz?

Außerdem ist es wichtig, zu wissen, dass eine hohe Latenz besteht, wenn während der Datenübertragung im Streaming über 10 Sekunden zeitlicher Versatz entsteht. Dies wäre keine gute Kommunikationssituation, sondern zum Beispiel eine Liveübertragungsoption eines Inhalts.

Was ist gute Qualität?

Videoinhalte sind hochwertig, wenn sie eine hohe Bildrate, hohe Auflösung und eine hochwertige Farbdarstellung besitzen. Qualitativ hochwertiges Audio hat wenig Störgeräusche und die Bandbreite der Frequenz ist hoch. In Bezug zur Latenz bedeutet das Folgendes: Je besser die Qualität sein soll, desto wahrscheinlicher ist es, dass man mit einer etwas höheren Latenz streamen muss – und umgekehrt.

So funktioniert Multimedia-Streaming

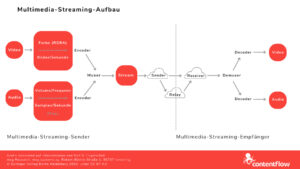

Wir erklären den Ablauf von Multimedia-Streaming im Allgemeinen anhand einer grafischen Darstellung – siehe Abbildung 1. Darin wird deutlich, dass beim Streaming Video- und Audiodaten über ein Netzwerk von einem Sender zu einem Empfänger oder mehreren Empfängern laufen. Es geht hier ums Streamen von Bewegtbildinhalten über das Internet, die beim Publikum zwar mit einer kleinen Verzögerung ankommen, aber sehr zeitnah angeschaut werden können. Auf der Grafik ist zu sehen, welchen Weg die Video- und Audioinhalte durchlaufen.

Abb. 1

Dabei stellen sich Nutzerinnen und Nutzer häufig die Frage, welche Streaming-Bandbreite sie fürs Livestreaming im Upload benötigen. Dazu haben wir einen extra Beitrag veröffentlicht, der das im Detail erklärt. Auch zu dieser Frage gibt es nicht nur eine pauschale Antwort.

Die gesendeten Datensegmente bestehen also aus den Videoinhalten, den Bildern, die pro Sekunde abgetastet werden, den Audioinhalten, in Samples pro Sekunde abgetastet, möglicherweise Untertitel in mehreren Sprachen, weiteren Datenpaketen mit Meta-Informationen und einem sogenannten Containerformat. Letzteres ist dafür zuständig, Video und Audio zusammen zu versenden. Hierbei ist wichtig, dass die Datenpakete mit den Zeitstempeln nah beieinander in das Containerformat verpackt werden, weil es sonst zu Latenzen zwischen Video und Audio kommen kann, also asynchrone Inhalte weitergeleitet werden. Video- und Audio-Codecs tragen Sorge für die Datenkompression. Die Datenkompressionsraten sind von den Inhalten abhängig, also bei Videodaten die Stärke der Bewegungen im Bild. Das wäre zum Beispiel eine Übertragung eines Fußballspiels, weil dort viele schnelle Bewegungen stattfinden.

Encoder schicken die Daten an einen Multiplexer (kurz: Muxer), der den eigentlichen Stream bedient. Die Grafik zeigt, wie der Livestream im folgenden über Demultiplexer (kurz: Demuxer) über Decoder zum Empfänger gelangt. Wer sich im Detail für Technische Informatik interessiert und was es genau mit Muxer und Demuxer auf sich hat, kann das zum Beispiel in einem Dokument der Universität Marburg nachlesen. Auch auf YouTube finden sich Informationen, hier beispielsweise in einem Video erklärt:

Tipps für die Einstellung von Encodern gibt es in einem anderen Contentflow-Beitrag zum Nachlesen.

Was ist das Problem mit der Latenzzeit beim Streaming?

Die schlechte Nachricht: Es ist derzeit schwer möglich, mit bester Qualität bei einer sehr geringen Latenz sehr viele Zuschauerinnen und Zuschauer zu erreichen, die zusätzlich viel im Stream interagieren. Das hängt mit den manchmal starken Kompressionsraten, En- und Decoding, Muxer-Demuxer-Komponenten und dem Relay-Service zusammen. Einfach gesagt, addieren sich auf dem Weg vom Sender zum Empfänger verschiedene technisch bedingte Latenzen.

Die gute Nachricht: Das ist in vielen Fällen auch gar nicht nötig. Anwendungsbeispiele der letzten Jahre haben gezeigt, dass Livestream-Veranstaltungen entweder in Form von Konferenzen, Workshops oder Meetings stattfinden oder als Liveübertragung (Broadcasting). Im ersten Fall nehmen oft weniger als 100 Leute teil und es gibt meist nur wenige Sprecherinnen und Sprecher – hier können interaktive Elemente im Fokus stehen. Im zweiten Fall wird beispielsweise ein großes Event live an sehr viele, mehr als 100 Empfänger, übertragen. Hier geht es in erster Linie darum, dass die Qualität einwandfrei ist. Also nimmt man entweder eine weniger gute Qualität oder eine höhere Latenz in Kauf.

Wie kann man das Problem lösen?

Natürlich gibt es auch Anwendungsbeispiele im Livestreaming-Business, wo am besten alle Faktoren optimiert sein sollten. Hier gilt es dann, den besten Kompromiss zwischen guter Qualität und niedriger Latenz zu finden. Man entscheidet sich dann, welche der Dimensionen fürs jeweilige Projekt optimiert sein sollten.

Die Problemlösung erklären wir an den zwei erwähnten Beispielen:

- Im Konferenz-Szenario ist es empfehlenswert, eine niedrige Latenz einzustellen. Das verringert zwar die Qualität und setzt eine geringere Zahl an Teilnehmern voraus, verbessert aber dafür die bidirektionale audiovisuelle Kommunikation zwischen den Teilnehmern.

- Im Broadcasting-Szenario muss die Qualität hochwertig sein. Zudem gibt es viele Teilnehmer, was dazu führt, dass die Latenz höher eingestellt wird. Das macht eine Kommunikation schwieriger, aber nicht unmöglich. Diese Kommunikation findet dann wahrscheinlich aber nicht audiovisuell statt.

Einige Übertragungsprotokolle (Beispiel: WebRTC) unterstützen bereits geringe Latenzen. Andere (Bsp.: SRT) bedienen sich der Relay-Services und schaffen es, relativ große Teilnehmergruppen abzudecken. Man kann auch einer Problemlösung näherkommen, indem im Livestream nur wenige oder ein einziger Sprecher in einer hohen Auflösung übertragen werden. Erfahrungswerte haben außerdem gezeigt, dass es zwar wünschenswert ist, wenn sich das gesamte Publikum mit Video in einen Livestream dazuschaltet, aber die Qualität insgesamt deutlich besser wird, wenn dies nicht der Fall ist.

Tipps fürs Einstellen der Latenz

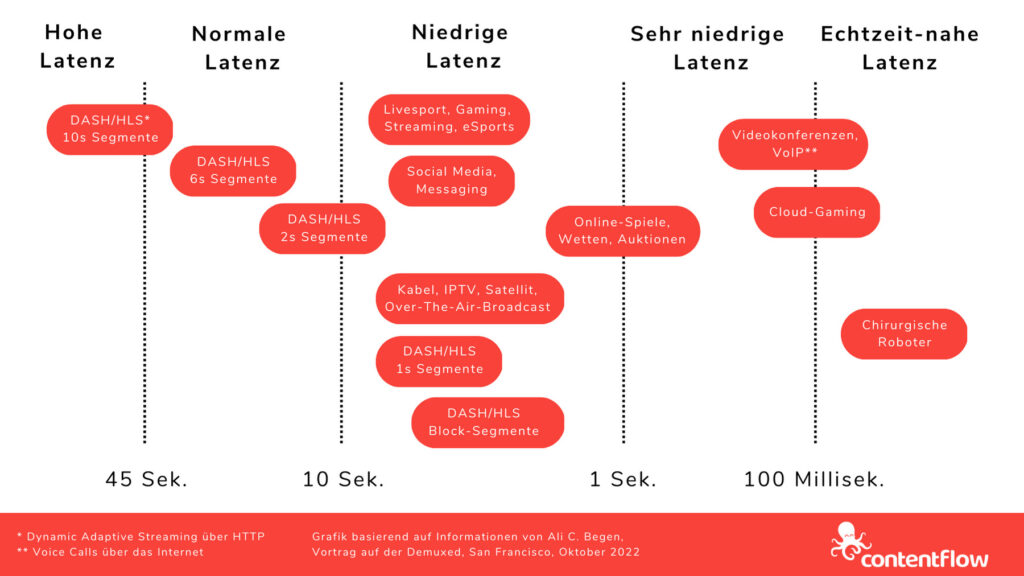

In der folgenden grafischen Darstellung zeigen wir, welche Livestream-Vorhaben in Kombination mit welchen Latenzen ratsam sind.

Der Video-Social-Media-Riese YouTube bietet drei Livestreaming-Latenz-Optionen an: normal, niedrig, extrem niedrig. Nutzerinnen und Nutzer können diese im „Live Control Room“ anpassen. YouTube empfiehlt, eine normale Latenz einzustellen, wenn man nicht mit den Nutzern interagieren und eine hohe Qualitat haben möchte. Eine niedrige Latenz hingegen erlaube eine sehr Echtzeit-nahe Kommunikation. Die Option der extrem niedrigen Latenz eigne sich für eine verstärkte Interaktion, wobei der Livestream jedoch Gefahr läuft, zu ruckeln.

Auch der Video-Service Vimeo hat einen Button integriert, der „Low latency-streaming“ unterstützt. Allerdings sei es dann aber nicht möglich, automatisierte Untertitel zu nutzen, so Vimeo. Man muss sich also überlegen, was wichtiger ist und die Hinweise dazu lesen.

Auch bei Contentflow lässt sich die Latenz anpassen. Du kannst hier einstellen, wenn Du eine besonders geringe Latenz möchtest oder wenn es eine sehr hohe Latenzzeit sein soll. Bei einer sehr hohen Latenz bekommen die Nutzerinnen und Nutzer die Möglichkeit, einen Livestream auch zeitversetzt anzuschauen. Das bedeutet, sie können je nach Einstellung entweder eine Stunde zeitversetzt schauen, bei einer besonders hohen Latenz sogar mehrere Stunden.

Wie Du in der Abbildung 2 sehen kannst, wird eine sehr niedrige Latenz vor allem bei Videokonferenzen und einigen speziellen Anwendungen wie Auktionen benötigt. Für die meisten Anwendungsfelder ist eine normale oder niedrige Latenz ausreichend. Und bei einer reinen Übertragung, bei der eine sehr gute Qualität wichtig ist, kann es auch eine hohe Latenz sein.

Abb. 2

Die Option bei einer Livestreaming-Software, die Latenz anzupassen, ist eine wichtige Funktion, um möglichst vielen Livestream-Projekten gerecht werden zu können. So kannst Du die Round-Trip-Zeit zwischen Sender und Empfänger gleichermaßen so schnell wie möglich und so hochqualitativ wie nötig gestalten. Überlege also vor Deinen Livestreams, welche Faktoren Dir wichtig sind, und wähle dann eine geeignete Latenz aus.

Dieses Projekt wurde kofinanziert durch das Programm „Horizont 2020“ der Europäischen Union unter der Grant Agreement Nr. 876239, 959379 & 965502.

Dieses Projekt wurde kofinanziert durch das Programm „Horizont 2020“ der Europäischen Union unter der Grant Agreement Nr. 876239, 959379 & 965502.